فایل robots.txt یک فایل متنی ساده است که در دایرکتوری اصلی (Root Directory) هر وبسایت قرار میگیرد. این فایل، اولین نقطهای است که رباتهای موتورهای جستجو (مانند گوگلبات، بینگبات و…) هنگام ورود به سایت شما، آن را بررسی میکنند.

به زبان ساده، robots.txt حاوی دستورالعملهایی برای این رباتها است و به آنها میگوید که:

- به کدام بخشها و صفحات سایت مجاز به ورود و خزش هستند.

- دسترسی آنها به کدام بخشها و فایلها (مانند فایلهای مدیریتی، صفحات ورود، صفحات تشکر، فایلهای رسانهای غیرضروری یا کدهای جاوا اسکریپت/CSS کماهمیت) باید مسدود شود.

- نقشه سایت (Sitemap) شما در کجا قرار دارد.

این فایل بر اساس «پروتکل حذف رباتها» (Robots Exclusion Protocol – REP) عمل میکند که مجموعهای از دستورالعملها برای ساماندهی به نحوه خزش رباتها در وب است.

🎯 اهمیت حیاتی Robots.txt در استراتژی سئو

اهمیت فایل robots.txt تنها در محدود کردن دسترسی خلاصه نمیشود، بلکه این فایل مستقیماً بر چندین فاکتور کلیدی در سئوی تکنیکال و کلی سایت تأثیر میگذارد:

۱. بهینهسازی بودجه خزش (Crawl Budget Optimization)

بودجه خزش به تعداد دفعات و میزان زمانی گفته میشود که موتورهای جستجو برای خزش در سایت شما اختصاص میدهند. این بودجه، به خصوص برای سایتهای بزرگ با هزاران صفحه یا سایتهایی با اعتبار دامنه (Domain Authority) متوسط، یک منبع محدود و ارزشمند است.

- مزیت Robots.txt: با استفاده از دستورات

Disallowدر robots.txt، میتوانید رباتها را از خزش در صفحات بیاهمیت، تکراری، صفحات مدیریتی، نتایج جستجوی داخلی یا صفحات سبد خرید و تسویهحساب منع کنید. - تأثیر بر سئو: وقتی رباتها وقت خود را صرف خزش در صفحات کمارزش نمیکنند، بودجه خزش آنها صرف صفحات اصلی، باکیفیت و مهم سایت شما (مانند صفحات محصول یا مقالات اصلی) میشود. این کار بهینهسازی منابع سرور را نیز به دنبال دارد و به ایندکس سریعتر و دقیقتر صفحات کلیدی شما کمک میکند، که مستقیماً بر رتبهبندی شما تأثیر میگذارد.

۲. مدیریت محتوای تکراری و نازک (Duplicate & Thin Content)

وجود محتوای تکراری (Duplicate Content) یا محتوای نازک (Thin Content – محتوای کمارزش و کوتاه) در یک سایت میتواند سیگنالهای منفی به موتورهای جستجو ارسال کند و به طور بالقوه به رتبه سئو آسیب بزند.

- نقش Robots.txt: بسیاری از صفحات، مانند صفحات برچسبهای خودکار (Tag Pages)، صفحات فیلتر و مرتبسازی در سایتهای فروشگاهی یا صفحات پارامتردار (URLهای دارای علامت سوال و پارامتر)، میتوانند به تولید محتوای تکراری منجر شوند. با مسدود کردن خزش این URLها در robots.txt، جلوی بررسی و تشخیص تکراری بودن آنها توسط رباتها را میگیرید.

- توجه: اگرچه برای مدیریت محتوای تکراری، استفاده از تگهای Canonical و Noindex روشهای قویتری هستند (به خصوص برای جلوگیری از ایندکس شدن کامل)، اما robots.txt میتواند از هدر رفتن بودجه خزش برای این صفحات جلوگیری کند.

۳. محافظت از فایلهای غیرعمومی و رسانهای

بسیاری از سایتها دارای فایلها و پوشههایی هستند که نباید در نتایج جستجو نمایش داده شوند یا حاوی اطلاعات محرمانه هستند.

- کاربرد امنیتی و سئویی:

- امنیتی: مسدود کردن دسترسی به پوشههای حساس مدیریتی (مانند

/wp-admin/در وردپرس) یا فایلهای پیکربندی. هرچند Robots.txt یک راهحل امنیتی کامل نیست و برای حفاظت قطعی باید از روشهای قویتری مانند رمزگذاری استفاده شود، اما یک لایه دفاعی اولیه محسوب میشود. - سئویی: جلوگیری از ایندکس شدن فایلهای رسانهای مانند PDFهای داخلی، تصاویر کمکیفیت یا ویدئوهای خصوصی که نباید مستقیماً در نتایج جستجو نمایش داده شوند. این امر به تمیزی نتایج جستجوی سایت شما کمک میکند.

- امنیتی: مسدود کردن دسترسی به پوشههای حساس مدیریتی (مانند

۴. بهبود ساختار و معماری سایت

فایل robots.txt با اعلام صریح بخشهای مهم و غیرمهم سایت، به موتورهای جستجو کمک میکند تا اولویتبندی صحیحی از محتوای شما داشته باشند و ساختار سایت شما را بهتر درک کنند.

- معرفی نقشه سایت (Sitemap): یکی از مهمترین دستورات در robots.txt، معرفی آدرس نقشه سایت XML است. این کار به رباتها کمک میکند تا تمام صفحات مهمی که شما میخواهید ایندکس شوند را به راحتی پیدا کنند و هیچ صفحهای از قلم نیفتد.

🛠️ ساختار و دستورات کلیدی Robots.txt

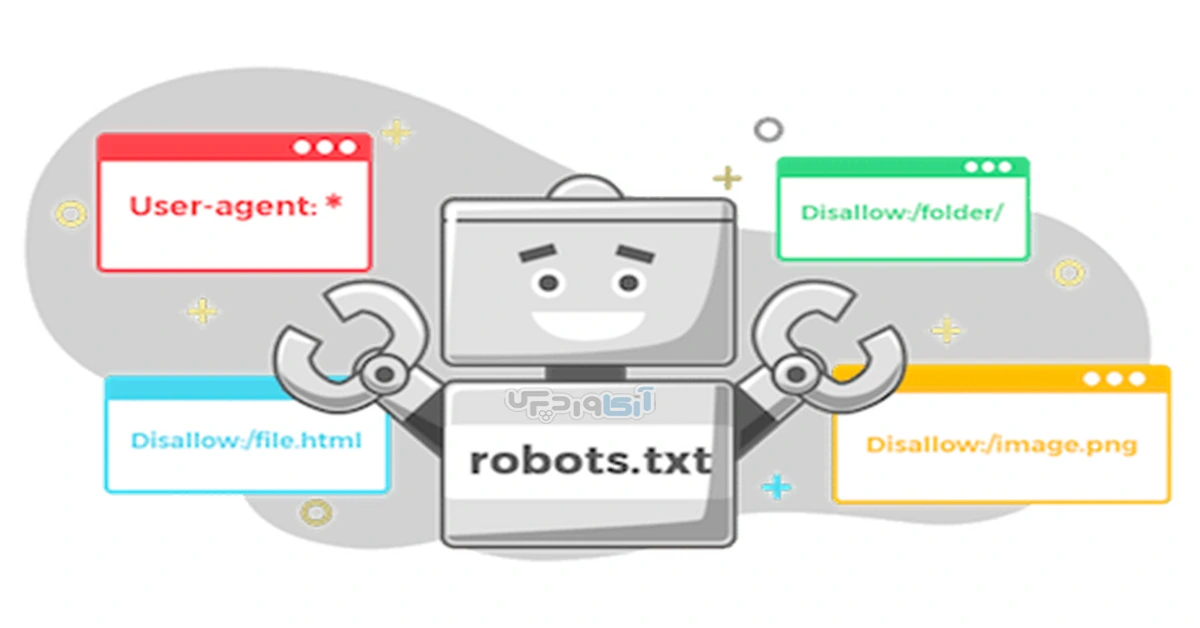

فایل robots.txt از ترکیب دستورات سادهای تشکیل شده است که هر یک وظیفه مشخصی دارند. هر دستور از دو بخش اصلی تشکیل میشود: User-agent (تعیین ربات) و Directive (دستورالعمل).

۱. User-agent

این دستور مشخص میکند که دستورالعملهای بعدی برای کدام رباتهای جستجو اعمال میشود.

User-agent: *: این علامت ستاره (*) به معنای همه رباتها است. این یک دستورالعمل عمومی است که برای تمامی موتورهای جستجو اعمال میشود.User-agent: Googlebot: دستورالعملهای بعدی فقط برای ربات جستجوی اصلی گوگل اعمال میشود.User-agent: Bingbot: دستورالعملهای بعدی فقط برای ربات جستجوی بینگ اعمال میشود.

۲. Disallow (عدم اجازه خزش)

مهمترین دستور در این فایل است و به رباتها میگوید که نباید بخشهای مشخص شده را خزش کنند.

Disallow: /: مسدود کردن دسترسی به تمام سایت (بسیار خطرناک! فقط برای سایتهای در حال ساخت یا خصوصی استفاده شود).Disallow: /wp-admin/: مسدود کردن پوشه مدیریتی وردپرس.Disallow: /images/: مسدود کردن خزش پوشه تصاویر.Disallow: /*?: مسدود کردن تمام URLهایی که دارای پارامتر هستند (مانند نتایج جستجوی داخلی یا فیلترها).

۳. Allow (اجازه خزش)

گاهی اوقات ممکن است یک پوشه اصلی را با Disallow مسدود کرده باشید، اما بخواهید به یک فایل یا زیرشاخه خاص در آن پوشه اجازه خزش بدهید. Allow برای لغو دستور Disallow در یک مسیر خاص استفاده میشود. گوگل همیشه به دستورالعملهای خاصتر و محدودکننده کمتر اولویت میدهد.

- مثال: فرض کنید کل پوشه

/temp/را مسدود کردهاید اما میخواهید فایل مهمی در آنجا کرال شود:User-agent: * Disallow: /temp/ Allow: /temp/important-file.html

۴. Sitemap (نقشه سایت)

این دستور برای معرفی صریح محل قرارگیری نقشههای سایت XML شما به رباتها استفاده میشود. هرچند رباتها نقشههای سایت را از ابزارهایی مانند سرچ کنسول نیز پیدا میکنند، اما قرار دادن آن در robots.txt یک روش خوب است.

- مثال:

Sitemap: https://www.yourwebsite.com/sitemap.xml

❌ خطاهای رایج و پیامدهای سئویی Robots.txt

یک اشتباه کوچک در فایل robots.txt میتواند کل سئوی سایت شما را به خطر اندازد. از رایجترین خطاهای کاربران، میتوان به موارد زیر اشاره کرد:

| خطای رایج | پیامد سئویی | راهحل |

Disallow: / (مسدود کردن کل سایت) | فاجعه! رباتها هیچ صفحهای را کرال نمیکنند و سایت شما از نتایج جستجو حذف میشود. | بلافاصله دستور را حذف کنید. |

| مسدود کردن فایلهای CSS/JS ضروری | رباتها نمیتوانند سایت را به درستی رندر کنند و درک ضعیفی از طراحی و موبایلفرندلی بودن سایت شما خواهند داشت. | فایلهای CSS/JS که برای نمایش ضروری هستند را حتماً در حالت Allow نگه دارید. |

مسدود کردن صفحات مهم با Disallow | اگر صفحهای را با Disallow مسدود کنید، ربات آن را کرال نمیکند و متا تگهای داخلی صفحه مانند Noindex را نیز نمیخواند. در نتیجه، ممکن است URL صفحه در نتایج جستجو نمایش داده شود اما بدون توضیحات (Snippet). | برای جلوگیری از ایندکس شدن صفحات مهم، باید از تگ <meta name="robots" content="noindex"> در هدر صفحه استفاده کنید. (صفحه باید کرال شود تا ربات بتواند تگ Noindex را بخواند.) |

| فراموشی بهروزرسانی پس از تغییر ساختار | اگر ساختار URL یا نام پوشهها را تغییر دهید و robots.txt را بهروز نکنید، رباتها هنوز دستورالعملهای قدیمی و نادرست را دنبال میکنند. | پس از هر تغییر بزرگ در ساختار URLها، فایل robots.txt را بررسی و بهروز کنید. |

✅ بهینهسازی حرفهای فایل Robots.txt

برای تبدیل شدن فایل robots.txt از یک محافظ ساده به یک ابزار قدرتمند سئو، به نکات زیر توجه کنید:

- بررسی از طریق سرچ کنسول (Search Console): از ابزار Robots.txt Tester در گوگل سرچ کنسول استفاده کنید تا اطمینان حاصل کنید که دستورات شما به درستی عمل میکنند و هیچ صفحه مهمی به اشتباه مسدود نشده است.

- استفاده از وایلدکاردها (Wildcards): میتوانید از علامت ستاره (*) برای مطابقت با دنبالهای از کاراکترها استفاده کنید. برای مثال:

Disallow: /private/*.pdfتمامی فایلهای PDF در پوشه private را مسدود میکند. - قرارگیری در مسیر درست: فایل robots.txt باید حتماً در ریشه دامنه (Root Directory) قرار گیرد، مانند:

https://example.com/robots.txt. اگر فایل را در زیرپوشهها قرار دهید، رباتها آن را نخواهند خواند. - تعیین نرخ خزش (Crawl-Delay – برای برخی موتورها): اگر سرور شما دچار مشکل در پاسخگویی به درخواستهای خزش میشود، میتوانید با دستور

Crawl-delayبه برخی از موتورهای جستجو (مانند بینگ) اطلاع دهید که بین هر درخواست خزش، کمی صبر کنند تا فشار سرور کاهش یابد.

🛠️ ساختاردهی پیشرفته و بهینهسازی Robots.txt برای وردپرس

وردپرس به دلیل ساختار منعطف خود، معمولاً صفحات و فایلهایی تولید میکند که برای سئو بیاهمیت هستند یا نباید در نتایج جستجو ایندکس شوند. هدف ما این است که رباتها را از خزش این موارد منع کنیم تا بودجه خزش ما حفظ شود و بر صفحات کلیدی متمرکز شود.

۱. دستورات عمومی و ضروری

این دستورات باید تقریباً در تمام سایتهای وردپرسی اعمال شوند تا از دسترسی به مهمترین پوشههای غیرضروری جلوگیری شود:

| بخش | دستور robots.txt | توضیحات |

| تعیین رباتها | User-agent: * | اعمال دستورات زیر برای تمام رباتهای جستجو (Googlebot, Bingbot, etc.). |

| مسدود کردن پوشه مدیریت | Disallow: /wp-admin/ | حیاتیترین بخش. از خزش در پنل مدیریتی (که نباید ایندکس شود و شامل فایلهای حساس است) جلوگیری میکند. |

| مجوز به فایلهای حیاتی ادمین | Allow: /wp-admin/admin-ajax.php | این فایل برای عملکرد صحیح برخی افزونهها و بخشهای مهم سایت ضروری است و باید اجازه خزش داشته باشد. |

| مسدود کردن فایلهای افزونه/قالب موقت | Disallow: /wp-content/plugins/ | بسته به افزونهها، ممکن است برخی فایلهای موقت یا غیرضروری تولید شوند. اما این کار باید با احتیاط انجام شود. |

Disallow: /wp-content/themes/ | مسدود کردن فایلهای قالبها (اگرچه معمولاً برای سئو ضروری نیستند، اما میتوانند در مصرف بودجه خزش صرفهجویی کنند). | |

| مسدود کردن صفحات موقت و غیرضروری | Disallow: /wp-includes/ | شامل فایلهای هسته وردپرس که نیازی به ایندکس شدن ندارند. |

| تعیین محل نقشه سایت | Sitemap: https://yourdomain.com/sitemap_index.xml | مسیر نقشه سایت خود (که معمولاً توسط افزونههای سئو مانند یوآست یا رنک مث تولید میشود) را مشخص کنید. |

۲. مدیریت محتوای تکراری و نازک در وردپرس

وردپرس به طور پیشفرض مسیرهایی تولید میکند که اغلب محتوای تکراری یا کمارزش دارند و باید از خزش آنها جلوگیری کرد:

| بخش | دستور robots.txt | هدف سئویی |

| نتایج جستجوی داخلی | Disallow: /?s= | جلوگیری از خزش و هدر رفتن بودجه برای صفحات نتایج جستجوی کاربران سایت (که محتوای باکیفیت ندارند). |

| فیدها (Feeds) | Disallow: /*/feed/$ | جلوگیری از خزش فیدهای RSS/Atom که محتوای تکراری از محتوای اصلی شما هستند. |

| صفحات پیوست (Attachment Pages) | Disallow: /*/attachment/ | جلوگیری از خزش صفحات پیوست رسانهای که معمولاً محتوای بسیار نازکی دارند (اگرچه بهتر است این صفحات با ریدایرکت یا Canonical مدیریت شوند، Disallow یک لایه محافظ است). |

| صفحات برچسب و دستهبندی خاص | Disallow: /tag/ | مسدود کردن خزش تمام صفحات برچسب (اگر آنها را به عنوان صفحات نازک یا تکراری در نظر میگیرید). |

Disallow: /category/uncategorized/ | مسدود کردن دستهبندیهای پیشفرض و بیاهمیت. | |

| صفحات نویسندگان (Author Archives) | Disallow: /author/ | اگر سایت شما تکنویسنده است یا صفحات نویسندگان ارزش سئویی ندارند، میتوانید آنها را مسدود کنید تا محتوای تکراری ایجاد نشود. |

| URLهای دارای پارامتر | Disallow: /*?* | این دستور برای مسدود کردن هر URL دارای پارامتر (مانند فیلترهای فروشگاهی) بسیار مفید است و بودجه خزش را حفظ میکند. |

۳. نحوه ایجاد و قرار دادن فایل Robots.txt

- ایجاد فایل: یک فایل متنی ساده (با پسوند

.txt) بسازید. نام فایل باید دقیقاًrobots.txtباشد (حروف کوچک). - نوشتن دستورات: دستورات بهینهسازی شده بالا را داخل این فایل قرار دهید.

- آپلود: فایل

robots.txtرا در دایرکتوری اصلی (Root Directory) هاست خود (معمولاً پوشهpublic_htmlیاwww) آپلود کنید. - تست: آدرس

yourdomain.com/robots.txtرا در مرورگر وارد کنید تا مطمئن شوید فایل قابل دسترسی است. سپس حتماً از ابزار Robots.txt Tester در گوگل سرچ کنسول برای اعتبارسنجی دستورات استفاده کنید.

۴. مثال یک فایل Robots.txt بهینه وردپرسی

Plaintext

User-agent: *

# مسدود کردن تمام رباتها از بخشهای غیر ضروری و تکراری

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/cache/

Disallow: /wp-content/themes/

Disallow: /wp-login.php

Disallow: /register/

Disallow: /comments/feed/

Disallow: /*/trackback/

Disallow: /*/page/

Disallow: /*?*

Disallow: /tag/

Disallow: /author/

Disallow: /*/attachment/

Disallow: /*/feed/$

# اجازه دادن به فایلهای حیاتی برای عملکرد صحیح

Allow: /wp-admin/admin-ajax.php

Allow: /wp-content/uploads/

# تعیین محل نقشه سایت

Sitemap: https://yourdomain.com/sitemap_index.xml

⚠️ تفاوت حیاتی بین Disallow در Robots.txt و Noindex

این مهمترین نکته برای درک نقش robots.txt است:

| ویژگی | Robots.txt (Disallow) | متا تگ Robots (Noindex) |

| هدف اصلی | مدیریت خزش (Crawl) | مدیریت نمایهگذاری (Index) |

| نحوه عملکرد | به ربات میگوید وارد این صفحه نشو و آن را کرال نکن. | به ربات میگوید: این صفحه را کرال کن، اما آن را در نتایج جستجو نشان نده. |

| پیامد سئویی | اگر صفحه مهمی را Disallow کنید، ربات تگ Noindex را نمیخواند و ممکن است URL بدون توضیحات ایندکس شود (آسیب به سئو). | اگر صفحه کماهمیتی را Noindex کنید، بودجه خزش صرف کرال آن میشود (اتلاف بودجه خزش). |

| استفاده بهینه | برای صفحات غیرضروری که اصلاً نباید کرال شوند (مثل صفحات مدیریتی، فیلترها، URLهای پارامتردار). | برای صفحات مهمی که باید کرال شوند اما نباید ایندکس شوند (مانند صفحات تشکر، صفحات خاص A/B تست، صفحات فرود کمارزش). |

قاعده طلایی:

هرگز صفحهای را که میخواهید با استفاده از تگ

Noindexاز نتایج جستجو حذف کنید، در فایلrobots.txtبا دستورDisallowمسدود نکنید. اگر صفحهای دارایDisallowباشد، ربات نمیتواند وارد آن شود و تگNoindexرا ببیند و در نتیجه، ممکن است همچنان به صورت ناقص در نتایج جستجو باقی بماند.

📝 جمعبندی: Robots.txt، فرماندهی هوشمندانه خزش

فایل robots.txt فراتر از یک ابزار سئو تکنیکال ساده است؛ این فایل یک راه ارتباطی مستقیم و حیاتی با موتورهای جستجو است که به شما اجازه میدهد فرایند خزش را به صورت هوشمندانه هدایت کنید. با مسدود کردن دسترسی به صفحات کماهمیت، از اتلاف بودجه خزش جلوگیری کرده و مطمئن میشوید که قدرت سئوی شما صرف مهمترین صفحاتتان میشود.

به یاد داشته باشید که درک و مدیریت صحیح این فایل، یک ستون اصلی برای هر استراتژی سئوی موفق است. اگر این فایل به درستی تنظیم نشود، حتی بهترین محتواها نیز ممکن است هرگز شانس ایندکس شدن و رقابت در نتایج جستجو را پیدا نکنند.

حالا که با اهمیت استراتژیک فایل robots.txt آشنا شدید، وقت آن است که به جزئیات بیشتری در مورد ساختاردهی و دستورات پیشرفتهتر بپردازیم، به ویژه با تمرکز بر روی یکی از رایجترین سیستمهای مدیریت محتوا، یعنی وردپرس (WordPress).

با توجه به ساختار وردپرس و نیازهای رایج سئویی در این پلتفرم، میتوان یک فایل robots.txt بهینه و کارآمد نوشت.